- Установка и настройка Logstash

- Настройка Kibana

- Static-libs conflicts

- Системные требования

- Как работать с криптопро

- Установка и настройка Winlogbeat

- Онлайн курс по Kubernetes

- Помогла статья? Подписывайся на telegram канал автора

- Comments

- Настройка криптопро csp

- Установка Elasticsearch

- Centos 7 / 8

- Ubuntu / Debian

- Автоматическая очистка индексов в elasticsearch

- Установка Kibana

- Ubuntu/Debian

- Upgrade system

- Часто задаваемые вопросы по теме статьи (FAQ)

- Ubuntu 20. 04 настройка crypto-pro csp release ver

- Установка Filebeat для отправки логов в Logstash

Установка и настройка Logstash

Logstash устанавливается так же просто, как Elasticsearch и Kibana, из того же репозитория. Не буду еще раз показывать, как его добавить. Просто установим его и добавим в автозагрузку. Установка Logstash в Centos:

# yum install logstash

Установка Logstash в Debian/Ubuntu:

# apt install logstash

Добавляем logstash в автозагрузку:

# systemctl enable logstash. service

Запускать пока не будем, надо его сначала настроить. Основной конфиг logstash лежит по адресу /etc/logstash/logstash. yml. Я его не трогаю, а все настройки буду по смыслу разделять по разным конфигурационным файлам в директории /etc/logstash/conf. Создаем первый конфиг input. conf, который будет описывать прием информации с beats агентов.

Тут все просто. Указываю, что принимаем информацию на 5044 порт. Этого достаточно. Если вы хотите использовать ssl сертификаты для передачи логов по защищенным соединениям, здесь добавляются параметры ssl. Я буду собирать данные из закрытого периметра локальной сети, у меня нет необходимости использовать ssl. Теперь укажем, куда будем передавать данные. Тут тоже все относительно просто. Рисуем конфиг output. conf, который описывает передачу данных в Elasticsearch.

Что мы настроили? Передавать все данные в elasticsearch под указанным индексом с маской в виде даты. Разбивка индексов по дням и по типам данных удобна с точки зрения управления данными. Потом легко будет выполнять очистку данных по этим индексам. Я закомментировал последнюю строку. Она отвечает за логирование. Если ее включить, то все поступающие данные logstash будет отправлять дополнительно в системный лог. В centos это /var/log/messages. Используйте только во время отладки, иначе лог быстро разрастется дублями поступающих данных. Остается последний конфиг с описанием обработки данных. Тут начинается небольшая уличная магия, в которой я разбирался некоторое время. Расскажу ниже. Рисуем конфиг filter. conf.

Первое, что делает этот фильтр, парсит логи nginx с помощью grok, если указан соответствующий тип логов, и выделяет из лога ключевые данные, которые записывает в определенные поля, чтобы потом с ними было удобно работать. С обработкой логов у новичков возникает недопонимание. В документации к filebeat хорошо описаны модули, идущие в комплекте, которые все это и так уже умеют делать из коробки, нужно только подключить соответствующий модуль.

Модули filebeat работают только в том случае, если вы отправляете данные напрямую в Elasticsearch. На него вы тоже ставите соответствующий плагин и получаете отформатированные данные с помощью elastic ingest. Но у нас работает промежуточное звено Logstash, который принимает данные. С ним плагины filebeat не работают, поэтому приходится отдельно в logstash парсить данные. Это не очень сложно, но тем не менее. Как я понимаю, это плата за удобства, которые дает logstash. Если у вас много разрозненных данных, то отправлять их напрямую в Elasticsearch не так удобно, как с использованием предобработки в Logstash.

Для фильтра grok, который использует Logstash, есть удобный дебаггер, где можно посмотреть, как будут парситься ваши данные. Покажу на примере одной строки из конфига nginx. Например, возьмем такую строку из лога:

И посмотрим, как ее распарсит правило grok, которое я использовал в конфиге выше.

Собственно, результат вы можете сами увидеть в дебаггере. Фильтр распарсит лог и на выходе сформирует json, где каждому значению будет присвоено свое поле, по которому потом удобно будет в Kibana строить отчеты и делать выборки. Только не забывайте про формат логов. Приведенное мной правило соответствует дефолтному формату main логов в nginx. Если вы каким-то образом модифицировали формат логов, внесите изменения в grok фильтр. Надеюсь понятно объяснил работу этого фильтра. Вы можете таким образом парсить любые логи и передавать их в еластикс. Потом на основе этих данных строить отчеты, графики, дашборды.

Дальше используется модуль date для того, чтобы выделять дату из поступающих логов и использовать ее в качестве даты документа в elasticsearch. Делается это для того, чтобы не возникало путаницы, если будут задержки с доставкой логов. В системе сообщения будут с одной датой, а внутри лога будет другая дата. Неудобно разбирать инциденты.

Закончили настройку logstash. Запускаем его:

# systemctl start logstash. service

Можете проверить на всякий случай лог /var/log/logstash/logstash-plain. log, чтобы убедиться в том, что все в порядке. Признаком того, что скачанная geoip база успешно добавлена будет вот эта строчка в логе:

Теперь настроим агенты для отправки данных.

Настройка Kibana

Файл с настройками Кибана располагается по пути – /etc/kibana/kibana. yml. На начальном этапе можно вообще ничего не трогать и оставить все как есть. По умолчанию Kibana слушает только localhost и не позволяет подключаться удаленно. Это нормальная ситуация, если у вас будет на этом же сервере установлен nginx в качестве reverse proxy, который будет принимать подключения и проксировать их в Кибана. Так и нужно делать в production, когда системой будут пользоваться разные люди из разных мест. С помощью nginx можно будет разграничивать доступ, использовать сертификат, настраивать нормальное доменное имя и т. Если же у вас это тестовая установка, то можно обойтись без nginx. Для этого надо разрешить Кибана слушать внешний интерфейс и принимать подключения. Измените параметр server. host, указав ip адрес сервера, например вот так:

Если хотите, чтобы она слушала все интерфейсы, укажите в качестве адреса 0. После этого Kibana надо перезапустить:

# systemctl restart kibana. service

Можно продолжать настройку и тестирование, а когда все будет закончено, запустить nginx и настроить проксирование. Я настройку nginx оставлю на самый конец. В процессе настройки буду подключаться напрямую к Kibana. При первом запуске Kibana предлагает настроить источники для сбора логов. Это можно сделать, нажав на Add your data. К сбору данных мы перейдем чуть позже, так что можете просто изучить интерфейс и возможности этой веб панели

Периодически вы можете видеть в веб интерфейсе предупреждение:

server. publicBaseUrl is missing and should be configured when running in a production environment. Some features may not behave correctly.

Чтобы его не было, просто добавьте в конфиг Kibana параметр:

Или доменное имя, если используете его.

Static-libs conflicts

Even with the nudge, you may still get some conflicts. It’s possible they’re to do with USE=static-libs.

root #emerge -v1 “~virtual/libcrypt-2” –autounmask=n –usepkg=n –backtrack=9999

Системные требования

Для установки одиночного инстанса с полным набором компонентов ELK необходимы следующие системные ресурсы.

Системные требования для ELK Stack

минимальныерекомендуемые

CPU24+

Memory6 Gb8+ Gb

Disk10 Gb10+ Gb

Некоторое время назад для тестовой установки ELK Stack достаточно было 4 Gb оперативной памяти. На текущий момент с версией 7. 15 у меня не получилось запустить одновременно Elasticsearch, Logstash и Kibana на одной виртуальной машине с четырьмя гигабайтами памяти. После того, как увеличил до 6, весь стек запустился. Но для комфортной работы с ним нужно иметь не менее 8 Gb и 4 CPU. Если меньше, то виртуальная машина начинает тормозить, очень долго перезапускаются службы. Работать некомфортно.

В системных требованиях для ELK я указал диск в 10 Gb. Этого действительно хватит для запуска стека и тестирования его работы на небольшом объеме данных. В дальнейшем, понятное дело, необходимо ориентироваться на реальный объем данных, которые будут храниться в системе.

Как работать с криптопро

Имея необходимые сведения, используем программу в демонстрационном режиме. Вот инструкция, как бесплатно пользоваться КриптоПро:

Шаг 1. Загружаем файлы через продукты и вкладку СКЗИ КриптоПро CSP.

Шаг 2. Видим сообщение об ограниченном доступе. Пройдем предварительную регистрацию и ответим на несколько вопросов.

Шаг 3. Заполняем поля и отправляем запрос на регистрацию, совершаем дальнейшие действия на следующей странице. Обратим внимание на сообщение о сроке использования демонстрационной версии: 90 дней с момента установки. Передача прав на пользование приобретается в виде лицензии. Демо-версия рассчитана на работу при первичной установке продукта. При повторной попытке загрузки не произойдет.

Шаг 4. Выбираем дистрибутив, который соответствует операционной системе компьютера, и скачиваем его. Загружается быстро. Запускаем программный файл с расширением. ехе. Программная система безопасности предупредит о том, что в компьютер внесут изменения. Если согласны, нажимаем «Установить». Загружается модуль.

После того как установили последнюю версию, работайте с программой сразу. Если загружали предыдущие версии, перезагрузите компьютер сразу или отложите это действие.

Поговорим немного про средства электронной подписи (ЭП) с использованием отечественных ГОСТ-алгоритмов в Linux. Несмотря на то, что различные средства и интерфейсы по работе с ЭП в Linux развиты даже лучше, чем в Windows, использовать их не так просто.

Такое положение вещей сохранялось последние несколько лет. Но с конца 2021 года ситуация изменилась в лучшую сторону. Появилось сразу два продукта, которые позволяют работать с электронной подписью по стандарту ГОСТ и шифрованием без использования консоли – это Rosa Crypto Tool и Trusted eSign.

Оба эти продукта для работы с криптографией используют «КриптоПро CSP» для Linux. Поэтому, перед тем как обратиться к описанию самих продуктов, поговорим немного про «КриптоПро CSP». «КриптоПро CSP» под Linux — неоднозначный продукт. С одной стороны, это одно из самых распространенных и мощных сертифицированных средств по работе с криптографией как в Windows, так и в Linux.

С другой стороны, для простого человека пользоватся его интерфейсами даже в Windows не так-то просто. А в Linux доступен только консольный интерфейс. Надеюсь, что компания «КриптоПро» в курсе этой ситуации, и в будущем нас ждут новые красивые и удобные интерфейсы, как для Windows, так и для Linux. Для настройки нам понадобится:

- Любимый дистрибутив Linux. Я использовал Ubuntu Linux 16.04 LTS и ROSA Fresh GNOME R8;

- Сертифицированная версия КриптоПро CSP 4.0 R2 для Windows, UNIX и macOS;

- Рутокен ЭЦП 2.0.

Установка и настройка Winlogbeat

Для настройки централизованного сервера сбора логов с Windows серверов, установим сборщика системных логов winlogbeat. Для этого скачаем его и установим в качестве службы. Идем на страницу загрузок и скачиваем msi версию под вашу архитектуру – 32 или 64 бита. Запускаем инсталлятор и в конце выбираем открытие директории по умолчанию.

Создаем и правим конфигурационный файл winlogbeat. yml. Я его привел к такому виду:

Думаю, по тексту понятен смысл. Я разделил по разным индексам логи nginx, системные логи виндовых серверов и добавил отдельный индекс unknown_messages, в который будет попадать все то, что не попало в предыдущие. Это просто задел на будущее, когда конфигурация будет более сложная, можно будет ловить сообщения, которые по какой-то причине не попали ни в одно из приведенных выше правил. Я не смог в одно правило поместить оба типа nginx_error и nginx_access, потому что не понял сходу, как это правильно записать, а по документации уже устал лазить, выискивать информацию. Так получился рабочий вариант. После этого перезапустил logstash и пошел на windows сервер, запустил службу Elastic Winlogbeat 7. Подождал немного, пока появятся новые логи на виндовом сервере, зашел в Kibana и добавил новые индексы. Напомню, что делается это в разделе Stack Management -> -> Index Patterns. Добавляем новый индекс по маске winsrv-*. Можно идти в раздел Discover и просматривать логи с Windows серверов.

У меня без проблем все заработало в том числе на серверах с русской версией Windows. Все логи, тексты в сообщениях на русском языке нормально обрабатываются и отображаются. Проблем не возникло нигде. На этом я закончил настройку ELK стека из Elasticsearch, Logstash, Kibana, Filebeat и Winlogbeat. Описал основной функционал по сбору логов. Дальше с ними уже можно работать по ситуации – строить графики, отчеты, собирать дашборды и т. В отдельном разделе ELK Stack у меня много примеров на этот счет.

Онлайн курс по Kubernetes

Онлайн-курс по Kubernetes – для разработчиков, администраторов, технических лидеров, которые хотят изучить современную платформу для микросервисов Kubernetes. Самый полный русскоязычный курс по очень востребованным и хорошо оплачиваемым навыкам. Курс не для новичков – нужно пройти вступительный тест.

Если вы ответите “да” хотя бы на один вопрос, то это ваш курс:

- устали тратить время на автоматизацию?

- хотите единообразные окружения?;

- хотите развиваться и использовать современные инструменты?

- небезразлична надежность инфраструктуры?

- приходится масштабировать инфраструктуру под растущие потребности бизнеса?

- хотите освободить продуктовые команды от части задач администрирования и автоматизации и сфокусировать их на развитии продукта?

Сдавайте вступительный тест по ссылке и присоединяйтесь к новому набору!.

Помогла статья? Подписывайся на telegram канал автора

Анонсы всех статей, плюс много другой полезной и интересной информации, которая не попадает на сайт.

Comments

but,conda has cudatoolkit 8. 0:$ conda search cudatoolkitcudatoolkit 8. 0 3 defaultsi use miniconda to install

Thank you for your reply, I have solved this problem. Thank you very much.

Настройка криптопро csp

Несмотря на то, что есть несколько неплохих статей по настройке КриптоПро CSP под Linux (например,

), я опишу здесь свой вариант. Основная причина в том, что большинство инструкций написаны для «Крипто Про CSP» версии 3. А современная версия КриптоПро CSP 4. 0 не является 100% совместимой с 3. Дополнительная причина — всегда приятно иметь полную инструкцию по настройке в одном месте, а не переключаться с одного окна на другое.

Приступаем к настройке. Скачиваем КриптоПро CSP для Linux с официального сайта КриптоПро и распаковываем:

tar -zxf. /linux-amd64_deb. tgz

Далее у нас есть 2 варианта: автоматическая установка и установка вручную. Автоматическая установка запускается командой sudo. /install. sh или sudo. /install_gui.

Здесь надо отдать должное разработчикам «КриптоПро» — автоматическая установка для большинства дистрибутивов отрабатывает успешно. Хотя бывают и нюансы. Например, если у вас не хватает некоторых пакетов, то установка будет успешно завершена, хотя некоторый функционал работать не будет.

Если что-то пошло не так, или вы по тем или иным причинам хотите использовать установку в ручном режиме, то вам необходимо выполнить:

dpkg -i. /cprocsp-curl-64_4. 0-4_amd64. deb lsb-cprocsp-base_4. 0-4_all. deb lsb-cprocsp-

capilite-64_4. 0-4_amd64. deb lsb-cprocsp-kc1-64_4. 0-4_amd64. deb lsb-cprocsp-rdr-64_4. 0-4_amd64. deb

Для установки пакетов в ROSA используйте urpmi , вместо dpkg -i.

Устанавливаем лицензию для «КриптоПро CSP» для Linux и проверяем, что все работает нормально:

cpconfig -license -set

cpconfig -license –view

Мы должны получить что-то вроде:

License validity:

XXXXX-XXXXX-XXXXX-XXXXX-XXXXX

Expires: 3 month(s) 2 day(s)

License type: Server.

Which python version are you using?

Activate the conda environment and then use python –version.

I tried to install AbiPy with:conda install abipy -c abinit

on Mac and Linux and python 3. 6 and the installation completed successfully

(windows is not supported)

Did you add conda-forge and matsci to the default channels withconda config –add channels conda-forge

conda config –add channels matsci

conda config –add channels abinit

If this does not solve your problem, you may try:inside your conda environment.

Установка Elasticsearch

Устанавливаем ядро системы по сбору логов – Elasticsearch. Его установка очень проста за счет готовых пакетов под все популярные платформы.

Centos 7 / 8

Копируем публичный ключ репозитория:

Подключаем репозиторий Elasticsearch:

# mcedit /etc/yum. repos. d/elasticsearch. repo

Приступаем к установке еластика:

# yum install –enablerepo=elasticsearch elasticsearch

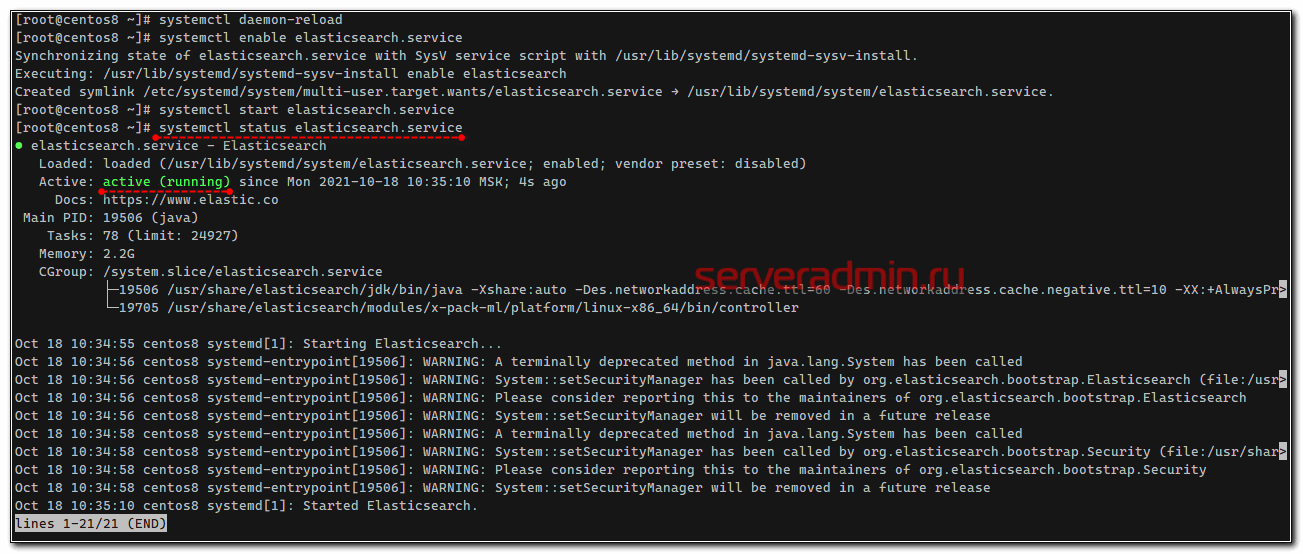

В в завершении установки добавим elasticsearch в автозагрузку и запустим его с дефолтными настройками:

# systemctl daemon-reload

# systemctl enable elasticsearch. service

# systemctl start elasticsearch. service

Проверяем, запустилась ли служба:

# systemctl status elasticsearch. service

Проверим теперь, что elasticsearch действительно нормально работает. Выполним к нему простой запрос о его статусе.

Все в порядке, сервис реально запущен и отвечает на запросы.

Ubuntu / Debian

Копируем себе публичный ключ репозитория:

Добавляем репозиторий Elasticsearch в систему:

Если вы выполняете установку с российских ip адресов, то доступ к репозиториям elastic будет заблокирован. Используйте зеркало Yandex.

Устанавливаем Elasticsearch на Debian или Ubuntu:

# apt update && apt install elasticsearch

После установки добавляем elasticsearch в автозагрузку и запускаем.

# systemctl daemon-reload

# systemctl enable elasticsearch. service

# systemctl start elasticsearch. service

Проверяем, запустился ли он:

Если все в порядке, то переходим к настройке Elasticsearch.

Автоматическая очистка индексов в elasticsearch

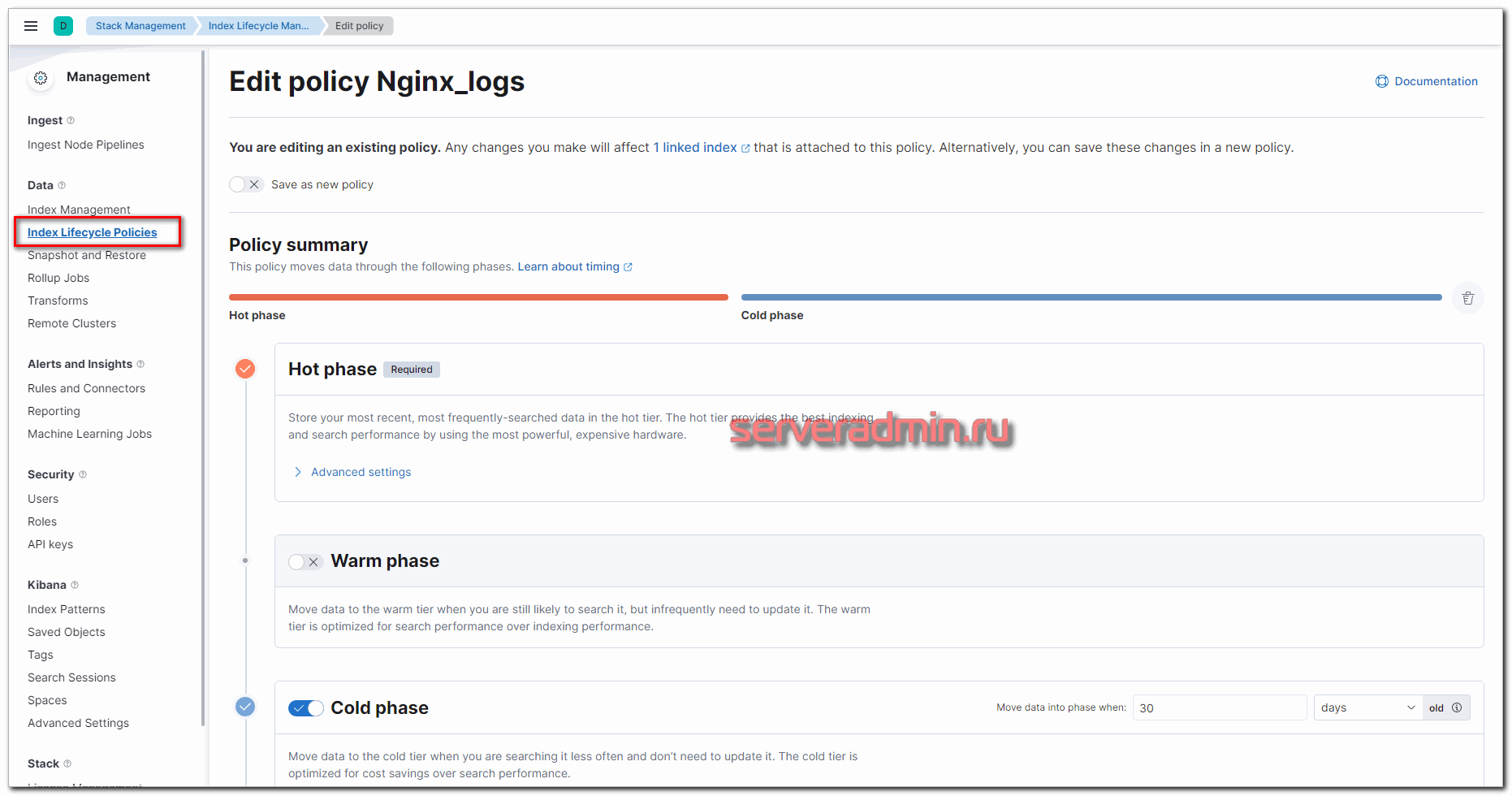

Некоторое время назад для автоматической очистки индексов в Elasticsearch необходимо было прибегать к помощи сторонних продуктов. Наиболее популярным был Curator. Сейчас в Kibana есть встроенный инструмент для очистки данных – Index Lifecycle Policies. Его не трудно настроить самостоятельно, хотя и не могу сказать, что там всё очевидно. Есть некоторые нюансы, так что я по шагам расскажу, как это сделать. Для примера возьму всё тот же индекс nginx-*, который использовал ранее в статье.

Настроим срок жизни индексов следующим образом:

- Первые 30 дней – Hot phase. В этом режиме индексы активны, в них пишутся новые данные.

- После 30-ти дней – Cold phase. В этой фазе в индексы невозможна запись новых данных. Запросы к этим данным имеют низкий приоритет.

- Все, что старше 90 дней удаляется.

Чтобы реализовать эту схему хранения данных, идем в раздел Stack Management -> Index Lifecycle Management и добавляем новую политику. Я её назвал Nginx_logs. Выставляем параметры фаз в соответствии с заданными требованиями.

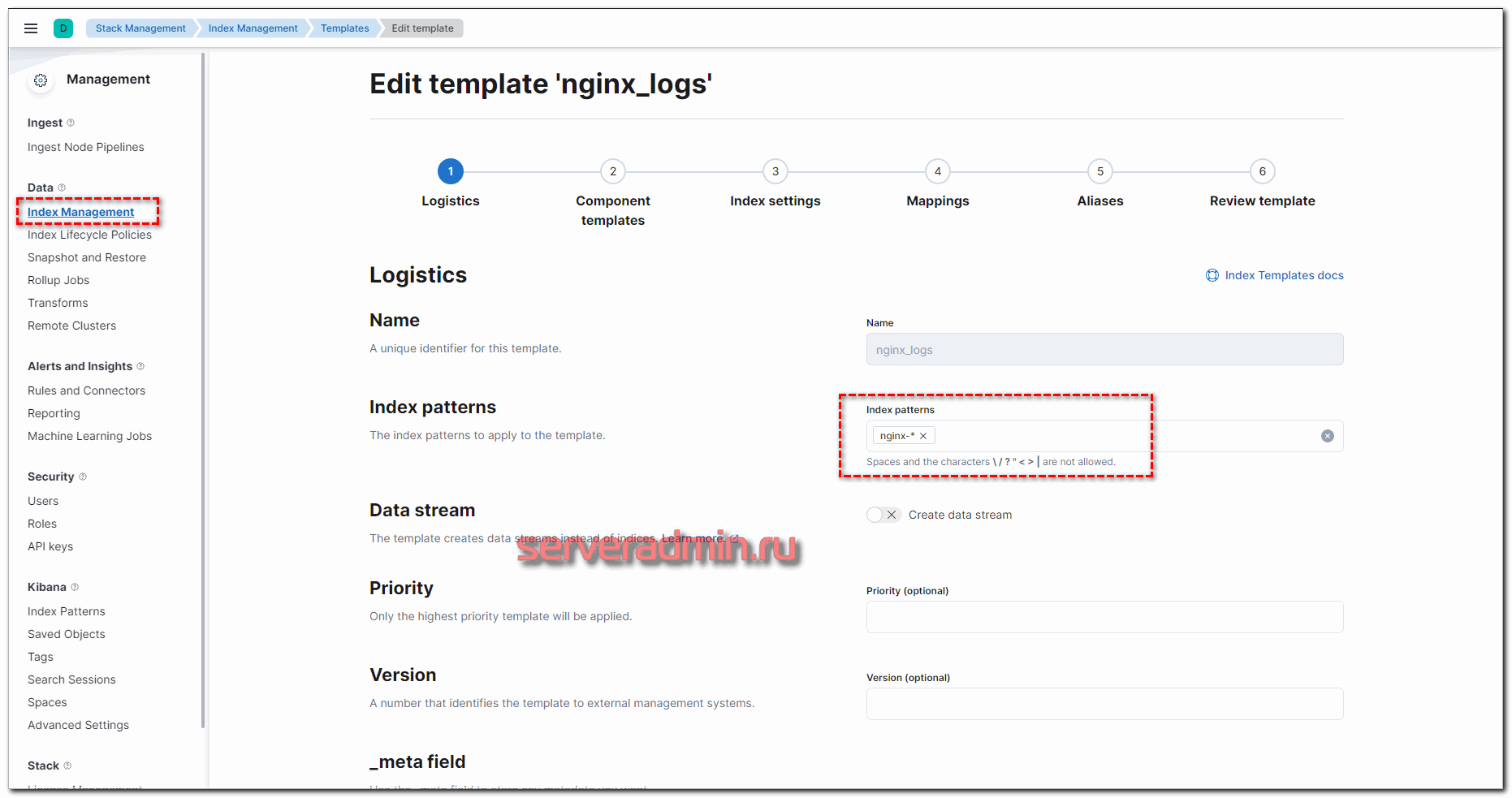

Не уместилось полное изображение настроек, но, думаю, вы там сами разберётесь, что выбрать. Ничего сложного тут нет. Далее нам нужно назначить новую политику хранения данных к индексам. Для этого переходим в Index Management -> Index Templates и добавляем новый индекс. В качестве шаблона укажите nginx-*, все остальные параметры можно оставить дефолтными.

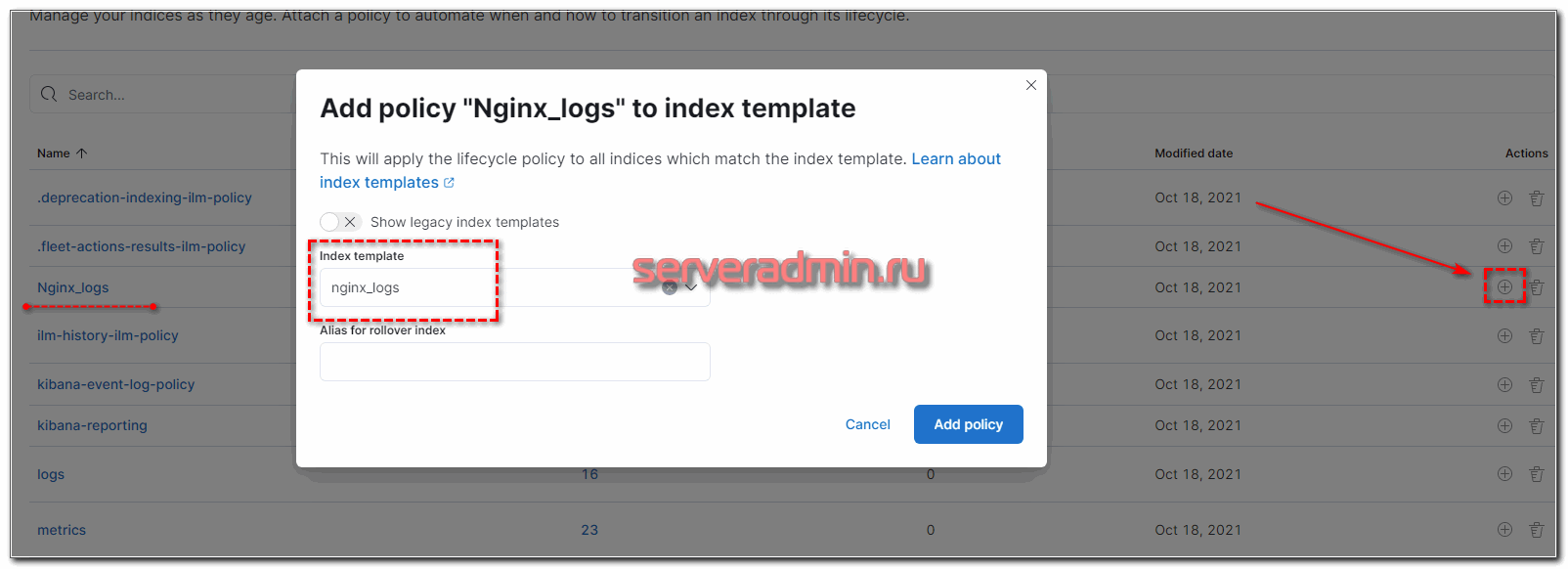

Теперь возвращаемся в Index Lifecycle Policies, напротив нашей политики нажимаем на + и выбираем только что созданный шаблон.

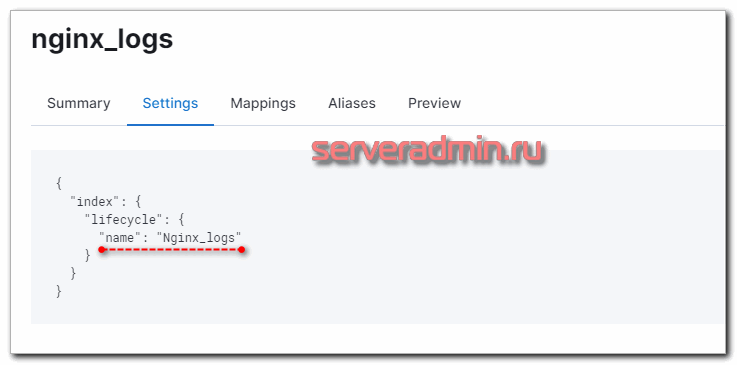

Проверяем свойства шаблона и убеждаемся в том, что Lifecycle Policies применилась.

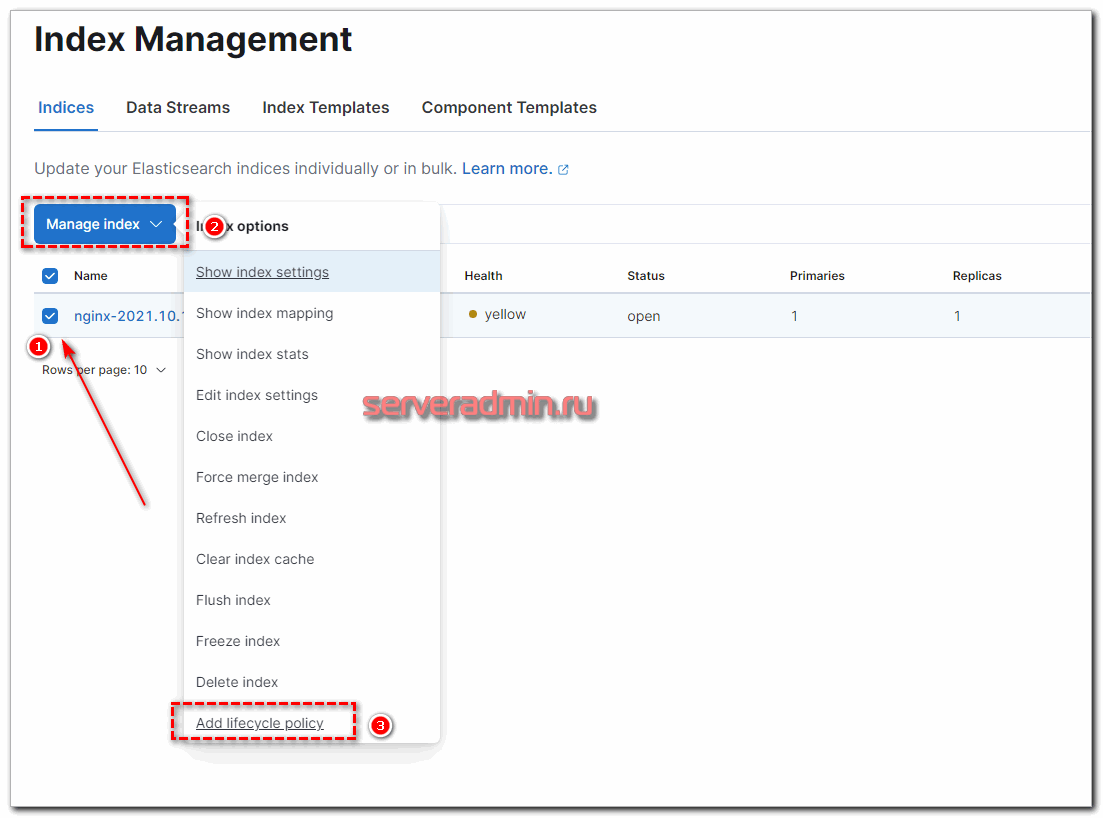

Теперь ко всем новым индексам, созданным по этому шаблону, будет применяться политика хранения данных. Для уже существующих это нужно проделать вручную. Достаточно выбрать нужный индекс и в выпадающем списке с опциями выбрать нужное действие.

Такими несложными действиями можно настроить автоматическую очистку индексов встроенными инструментами Elasticsearch и Kibana. В некоторых случаях быстрее и удобнее воспользоваться Curator, особенно если нужно быстро реализовать много разных схем. Единый конфиг куратора выглядит более наглядным, но это уже вкусовщина и от ситуации зависит.

Установка Kibana

Дальше устанавливаем web панель Kibana для визуализации данных, полученных из Elasticsearch. Тут тоже ничего сложного, репозиторий и готовые пакеты есть под все популярные платформы. Репозитории и публичный ключ для установки Kibana будут такими же, как в установке Elasticsearch. Но я еще раз все повторю для тех, кто будет устанавливать только Kibana, без всего остального. Это продукт законченный и используется не только в связке с Elasticsearch.

Импортируем ключ репозитория:

Добавляем конфиг репозитория:

# mcedit /etc/yum. repos. d/kibana. repo

Запускаем установку Kibana:

# yum install kibana

Добавляем Кибана в автозагрузку и запускаем:

# systemctl daemon-reload

# systemctl enable kibana. service

# systemctl start kibana. service

Проверяем состояние запущенного сервиса:

# systemctl status kibana. service

По умолчанию, Kibana слушает порт 5601. Только не спешите его проверять после запуска. Кибана стартует долго. Подождите примерно минуту и проверяйте.

Ubuntu/Debian

Установка Kibana на Debian или Ubuntu такая же, как и на центос – подключаем репозиторий и ставим из deb пакета. Добавляем публичный ключ:

Добавляем рпозиторий Kibana:

# apt update && apt install kibana

Upgrade system

Perform a full world upgrade again. If all is going well, there should be many rebuilds caused by virtual/libcrypt.

Часто задаваемые вопросы по теме статьи (FAQ)

Можно ли вместо filebeat использовать другие программы для сбора логов?

Да, можно. Наиболее популярной заменой filebeat является Fluentd. Она более функциональна и производительна. В некоторых случаях может взять на себя часть функционала по начально обработке данных. В итоге, можно отказаться от logstash.

Можно ли в данной связке обойтись без logstash?

Да, если вы просто собираете логи, без предварительной обработки и изменения, можно отправлять данные напрямую в elasticsearch. На нем их так же можно обработать с помощью grok фильтра в elastic node. Вариант рабочий, но не такой функциональный, как logstash.

Есть ли в elasticsearch какой-то штатный механизм очистки старых данных?

Да, есть такой механизм – Index Lifecycle Policies, который требует отдельной настройки в Kibana. Также можно использовать сторонний софт. Пример такого софта – curator.

Как штатно настроить tls сертификат в Kibana?

Проще всего использовать для этого nginx в режиме proxy_pass. С его помощью можно без проблем подключить бесплатные сертификаты от Let’s Encrypt.

Какие минимальные системные требования для запуска ELK Stack?

Начать настройку можно с 2CPU и 6Gb RAM. Но для более ли менее комфортной работы желательно 8G RAM.

Ubuntu 20. 04 настройка crypto-pro csp release ver

Установка Crypto-Pro CSP Release Ver:5. 11455

tar -zxf linux-amd64_deb. tgzcd linux-amd64_debsudo. /install_gui

Ввести лицензию.

/opt/cprocsp/bin/amd64/csptest -keyset -verifycontext

/opt/cprocsp/bin/amd64/csptestf -absorb -certs -autoprov

Сертификаты которые ставит Crypto-Pro:

sudo /opt/cprocsp/bin/amd64/certmgr -list -store mRoot

Получим уникальное имя для манипуляций с контейнером:

/opt/cprocsp/bin/amd64/csptest -keys -enum -verifyc -fqcn -unique

Установить скопированный контейнер:

/opt/cprocsp/bin/amd64/certmgr -inst -store uMy -cont ‘. HDIMAGEHDIMAGEu2020. 0009D5E‘

Установим сертификат:cd ~//opt/cprocsp/bin/amd64/certmgr -inst -store uMy -file vu2020. cer -cont ‘. HDIMAGEHDIMAGEu2020. 0009D5E‘

Просмотор личных сертификатов:

/opt/cprocsp/bin/amd64/certmgr -list -store uMy

Сделан не в той кодировке.

/opt/cprocsp/bin/amd64/certmgr -inst -store uMy -cont ‘. HDIMAGEHDIMAGEamwpxjbm. 000F8E3‘

Установим сертификат:cd ~//opt/cprocsp/bin/amd64/certmgr -inst -store uMy -file 9246050. cer -cont ‘. HDIMAGEHDIMAGEamwpxjbm. 000F8E3‘

Просмотор промежуточных сертификатов:

/opt/cprocsp/bin/amd64/certmgr -list -store uCa

Установка промежуточных сертификатов:

/opt/cprocsp/bin/amd64/certmgr -inst -cert -file cert_2020. cer -store uCa

Просмотор корневых сертификатов:

Установка корневых сертификатов:

/opt/cprocsp/bin/amd64/certmgr -inst -cert -file uts-fk_2020. cer -store mRoot

CryptCP 4. 0 (c) “КРИПТО-ПРО”, 2002-2021.

Действителен с 17. 2021 13:07:32 по 17. 2020 13:07:32

Не работает разобраться: #Для того, чтобы не вводить каждый раз полный путь к утилитам КриптоПро CSP, в терминале #следует ввести команду:

sudo apt install alien

cp ~/Загрузки/cades_linux_amd64. tar. gz ~/

tar -zxf cades_linux_amd64. tar

Установить плагин: sudo alien -dc cprocsp-pki-2. 0-amd64-cades. rpmsudo alien -dc cprocsp-pki-2. 0-amd64-plugin. rpmsudo dpkg -i cprocsp-pki-cades_2. 0-2_amd64. deb cprocsp-pki-plugin_2. 0-2_amd64. deb

Установить расширение firefox на страничке с проверкой плагина:Проверка плагинаНиже инструкция (не нужна) Настройка firefox на установку дополненийУправление списком надежных веб-узлов на Unix-платформах

Проверить подпись.

Для работы будем пользоваться chromium-gostБерем здесь

#$ sudo apt install chromium – нельзя зайти не zakupki. gov

Заменить:#Exec=/usr/bin/chromium-gost-stable %UExec=/usr/bin/chromium-gost-stable %U –password-store=basic

#Exec=/usr/bin/chromium-gost-stable –incognitoExec=/usr/bin/chromium-gost-stable –incognito –password-store=basic

Для работы с сайтом госуслуг используем инструкцию ниже:Вход с помощью электронной подписи на портал Госуслуг на Linux.

Плагин IFCPlugin-3. 0-x86_64. deb. zip работать перестал!!!

Также установим расширение chrom для сайта госуслуг. Установить Расширение для gosuslugi. ru в браузере chromiumПерейти в меню – Дополнительные инструменты – Расширения и включить плагин

создаем симлинк для корректной работы связи расширения браузера с библиотекой установленного плагина sudo cp /etc/opt/chrome/native-messaging-hosts/ru. rtlabs. ifcplugin. json /etc/chromium/native-messaging-hosts

Вход на госуслуги

После этого успешно заходим на сайт госзакупок браузером chromium-gost !!!

После этого можно заходить на основные торговые площадки.

Проверено подписывает: Единая электронная торговая площадка

Проверно подписывает: Сбербанк-АСТ

Управление списком надежных узлов:Открыть в браузере: /etc/opt/cprocsp/trusted_sites. html

Подпись документа с отсоединенной электронной подписью:

Проверка подписи документа с отсоединенной электронной подписью:

/opt/cprocsp/bin/amd64/cryptcp -verify -verall -detached ‘ГК 0002. docx’ ‘ГК 0002. docx. sig’

Установка Filebeat для отправки логов в Logstash

В Debian/Ubuntu ставим так:

# yum install filebeat

# apt install filebeat

После установки рисуем примерно такой конфиг /etc/filebeat/filebeat. yml для отправки логов в logstash.

Некоторые пояснения к конфигу, так как он не совсем дефолтный и минималистичный. Я его немного модифицировал для удобства. Во-первых, я разделил логи access и error с помощью отдельного поля type, куда записываю соответствующий тип лога: nginx_access или nginx_error. В зависимости от типа меняются правила обработки в logstash. Плюс, я включил мониторинг и для этого указал адрес elastichsearch, куда filebeat передает данные мониторинга напрямую. Показываю это для вас просто с целью продемонстрировать возможность. У меня везде отдельно работает мониторинг на zabbix, так что большого смысла в отдельном мониторинге нет. Но вы посмотрите на него, возможно вам он пригодится. Чтобы мониторинг работал, его надо активировать в соответствующем разделе в Management – Stack Monitoring.

И не забудьте запустить elasticsearch на внешнем интерфейсе. В первоначальной настройке я указал слушать только локальный интерфейс. Запускаем filebeat и добавляем в автозагрузку.

# systemctl start filebeat

# systemctl enable filebeat

Проверяйте логи filebeat в дефолтном системном логе. По умолчанию, он все пишет туда. Лог весьма информативен. Если все в порядке, увидите список всех логов в директории /var/log/nginx, которые нашел filebeat и начал готовить к отправке. Если все сделали правильно, то данные уже потекли в elasticsearch. Мы их можем посмотреть в Kibana. Для этого открываем web интерфейс и переходим в раздел Discover. Так как там еще нет индекса, нас перенаправит в раздел Managemet, где мы сможем его добавить.

Новый индекс добавлен. Теперь при переходе в раздел Discover, он будет открываться по умолчанию со всеми данными, которые в него поступают.

Получение логов с веб сервера nginx на linux настроили. Подобным образом настраивается сбор и анализ любых логов. Можно либо самим писать фильтры для парсинга с помощью grok, либо брать готовые. Вот несколько моих примеров по этой теме:

- Мониторинг производительности бэкенда с помощью ELK Stack

- Сбор и анализ логов samba в ELK Stack

- Дашборд для логов nginx

Теперь сделаем то же самое для журналов windows.